Jakarta – Platform chatbot populer Character.AI resmi mengumumkan kebijakan baru yang membatasi akses fitur chat bagi pengguna berusia di bawah 18 tahun. Langkah ini dilakukan setelah perusahaan meluncurkan sistem “Age Assurance Model”, yakni model jaminan usia internal yang mampu mengklasifikasikan umur pengguna berdasarkan interaksi, tipe karakter yang diajak bicara, serta data pihak ketiga.

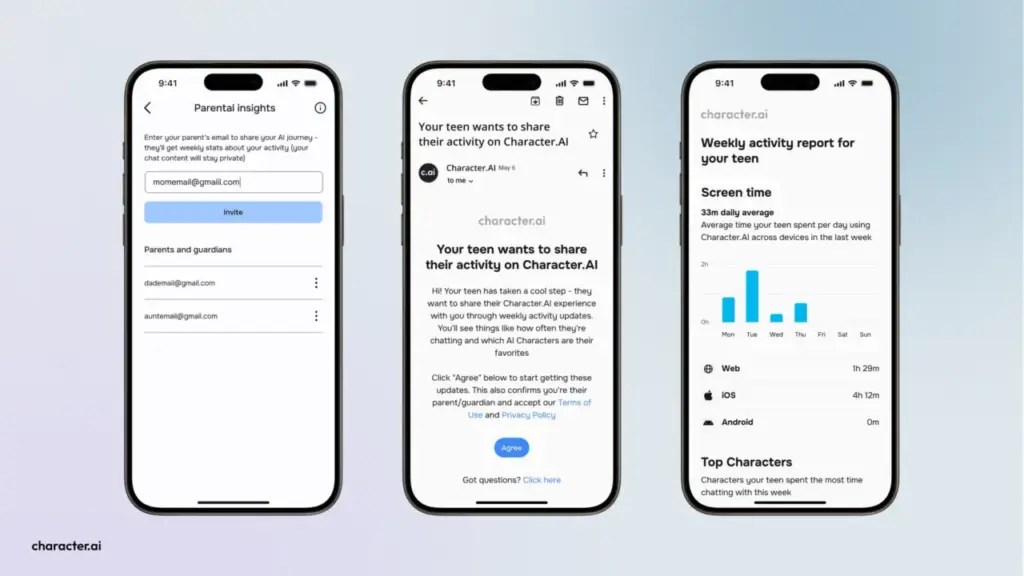

Mulai saat ini, pengguna yang terdeteksi masih di bawah umur akan diarahkan ke versi aplikasi ramah remaja. Mereka hanya diberi waktu dua jam per hari untuk menggunakan fitur chat hingga kebijakan larangan penuh diterapkan pada 25 November 2025.

Bagi pengguna dewasa yang salah teridentifikasi sebagai minor, Character.AI menyediakan proses verifikasi identitas melalui layanan Persona, yang memerlukan data resmi seperti kartu identitas.

CEO Character.AI, Karandeep Anand, menyebut kebijakan ini sebagai langkah “sangat berani” di tengah meningkatnya tekanan hukum dan regulasi pemerintah terkait perlindungan anak dalam interaksi dengan AI. Platform ini sebelumnya menghadapi gugatan dari orang tua yang menuduh anak mereka terlibat dalam percakapan tidak pantas dengan chatbot AI.

Meski fitur chat dibatasi, remaja tetap dapat mengakses riwayat obrolan lama serta menggunakan fitur lain seperti pembuatan karakter, video, dan cerita. Character.AI juga menyampaikan permintaan maaf kepada pengguna remajanya, sembari menegaskan komitmen mereka terhadap keamanan dan kepatuhan hukum